Зашто би решење за халуцинације вештачке интелигенције уништило четботове

Компанија "OpenAI" у новој студији објашњава зашто ChatGPT и други велики језички модели „халуцинирају“, феномен познат по томе да вештачка интелигенција измишља ствари, односно садржај одговора. Такође, из компаније кажу да знају како да реше проблем, али би имплементација решења уништила поверење корисника.

У новом раду је дата најстрожија математичка анализа до сада која објашњава зашто ови модели самоуверено износе нетачне тврдње. Показано је да то није само несрећна последица начина на који се тренутно тренирају, већ нешто што је математички неизбежно.

Део проблема проистиче из грешака у подацима који се користе за тренирање. Али, користећи математичку анализу начина на који системи ВИ уче, истраживачи су доказали да чак и уз савршене податке за обуку, проблем и даље остаје.

Начин на који језички модели одговарају на упите – предвиђајући једну по једну реч у реченици на основу вероватноћа – природно доводи до грешака. Истраживачи су показали да је укупна стопа грешака приликом генерисања реченица најмање двоструко већа од стопе грешке коју исти модел ВИ има на простим питањима типа „да/не“, јер се грешке акумулирају током више предвиђања.

Другим речима, стопа халуцинација је у основи ограничена тиме колико добро системи ВИ могу да разликују ваљане од неваљаних одговора. Пошто је овај проблем класификације по природи тежак у многим областима знања, халуцинације постају неизбежне.

Испоставља се и да што модел ређе током тренинга „види“ неку чињеницу, већа је вероватноћа да ће халуцинирати када се о томе пита. На пример, са рођенданима познатих личности показало се да ако се 20 одсто тих датума у подацима појављује само једном, онда би базни модели морали да погреше у најмање 20 одсто упита о рођенданима.

Заиста, када су истраживачи питали најнапредније моделе за рођендан Адама Калаја, једног од аутора рада, „Дип сик верзија три“ (DeepSeek-V3) је самоуверено понудио три различита, али нетачна датума: „03.07“, „15.06“ и „01.01“. Тачан датум је у јесен, тако да ниједан није био близу.

Замка евалуације

Још забрињавајуће је што анализа показује зашто халуцинације остају и након пост-тренинг напора (као што је давање људских повратних информација пре пуштања модела у јавност). Аутори су проучили десет главних модела, укључујући оне које користе „Гугл“, "OpenAI" и водеће ранг-листе за моделе. Открили су да њих девет користи бинарне системе оцењивања који дају нулу поена ако ВИ изрази несигурност.

То ствара оно што аутори називају „епидемијом“ кажњавања искрених одговора. Када систем каже „не знам“, добија исту оцену као и када да потпуно нетачан одговор. Тако оптимална стратегија постаје јасна – увек погађати, макар и погрешно.

Истраживачи су то и математички доказали. Без обзира на вероватноћу тачности, очекивани резултат од погађања увек премашује резултат од уздржавања ако евалуација користи бинарно оцењивање.

Решење које би све покварило

"OpenAI" предлаже да ВИ пре одговора процени сопствено самопоуздање у тачност и да бенчмаркови оцењују на тој основи. Тако би ВИ могла да добије инструкцију: „Одговори само ако си више од 75 одсто сигуран, јер грешке носе минус три поена, а тачни одговори плус један“.

Математички оквир истраживача показује да би под одговарајућим прагом сигурности ВИ системи природно изражавали несигурност уместо да погађају. То би смањило халуцинације. Проблем је, међутим, у корисничком искуству.

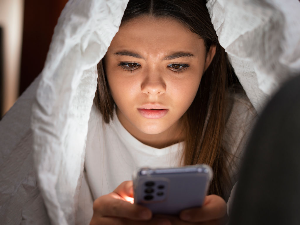

Замислите да ChatGPT почне да одговара са „не знам“ на чак 30 одсто упита, што је конзервативна процена на основу анализе чињеничне несигурности у подацима. Корисници навикнути да добијају самоуверене одговоре на готово свако питање врло брзо би напустили такав систем.

Проблем рачунарске економије

Не би било тешко смањити халуцинације користећи увиде из овог рада. Познате методе за квантификацију несигурности постоје деценијама. Оне би се могле користити за поуздане процене несигурности и усмеравање ВИ ка паметнијим изборима.

Али чак и ако би се превазишла препрека да се корисницима не свиђа ова несигурност, остаје још већи проблем – рачунарска економија. Модели свесни несигурности захтевају знатно више рачунарске снаге од данашњих, јер морају да процењују више могућих одговора и степена поузданости. За систем који дневно обрађује милионе упита то значи драстично веће оперативне трошкове.

Софистициранији приступи, као што је активно учење (где ВИ поставља додатна питања да би смањила несигурност), могу повећати тачност, али још више умножавају рачунарске захтеве.

Такви методи добро функционишу у специјализованим доменима као што је дизајн чипова, где погрешни одговори коштају милионе долара и оправдавају огромне ресурсе. Али за потрошачке апликације, где корисници очекују тренутне одговоре, економија постаје непремостива.

Коментари