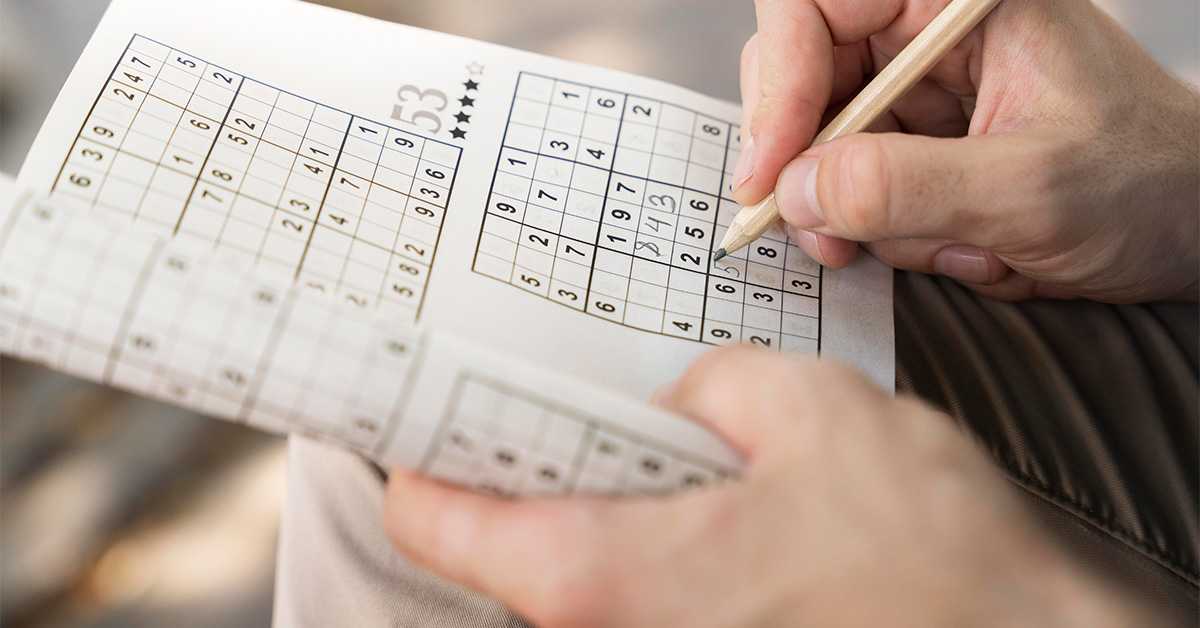

Вештачка интелигенција решава судоку, али не зна како

Истраживачи су замолили вештачку интелигенцију за помоћ у решавању судокуа. Резултат је био тачан. Али када је постављено питање о методи решавања – кренуло је лудило.

Вештачка интелигенција решава судоку, али не зна како

Вештачка интелигенција решава судоку, али не зна како

Судоку се сматра вежбом за мозак. Потребно је мало стрпљења и логичког размишљања. Али шта се дешава када се исти задатак постави вештачкој интелигенцији (ВИ)? Управо то су истражили научници са Универзитета Колорадо у Болдеру, САД – са прилично изненађујућим резултатом.

Неки модели ВИ, такозвани велики језички модели (LLM), могли су да реше једноставне судоку заадатке. Међутим, чак и најбољи међу њима давали су нејасна, нетачна или апсурдна објашњења о томе како су дошли до решења.

2.300 судокуа, много грешака

За експеримент, тим је креирао око 2.300 судоку загонетки у поједностављеном 6x6 формату. Тестирано је неколико модела ВИ, укључујући ChatGPT-o1-preview, који је тада био један од најнапреднијих система.

Док је о1 тачно решио око 65 процената судоку загонетки, други модели су били испод једног процента.

Временска прогноза уместо пута до решења

Али прави проблем се показао у следећем кораку: када је требало да модели ВИ објасне свој пут до решења.

„Понекад су ВИ објашњења измишљала чињенице", каже Ашутош Триведи, коаутор студије и ванредни професор информатике на Универзитету Колорада Болдеру. Или нису видели очигледна објашњења: „Тако је одговор рецимо био: 'Овде не може стајати двојка, јер у истом реду већ постоји двојка', али то није био случај."

У посебно упечатљивом примеру, ВИ је из непознатих разлога одговорио временском прогнозом.

„У том тренутку ВИ је потпуно полудела и била збуњена", каже коаутор студије Фабио Сомензи.

Тачан резултат није исто што и разумевање

Могли бисмо рећи: главно да је резултат тачан. Али за истраживаче, то је преједноставан поглед.

„Код одређених врста судокуа, већина ЛЛМ-ова је и даље неадекватна, посебно када је реч о стварању објашњења која су на било који начин корисна људима", каже Марија Пачеко, коауторка студије и доценткиња на одсеку за информатику. „Зашто је дошла до тог решења? Који су кораци које треба предузети да би се до њега стигло?"

Своје резултате тим је представио на стручној конференцији ACL 2025. Рад је такође објављен у часопису Findings of the Association for Computational Linguistics.

Размишљање или погађање?

Циљ студије није био да дискредитује ВИ, већ да открије како велики језички модели (LLM) заправо „размишљају".

Судоку је служио као тест, „микрокосмос за машинско одлучивање", како га назива Сомензи, професор на Факултету за електротехнику, рачунарство и енергетику.

„Ако дозволите вештачкој интелигенцији да вам изради пореску пријаву, желећете да пореској управи можете објаснити зашто је вештачка интелигенција написала то што је написала."

Централно откриће експеримента гласи: LLM-ови углавном не решавају судоку кроз систематско размишљање засновано на правилима, већ кроз статистичко погађање.

То је такође због њиховог начина функционисања: током развоја ChatGPT-а, на пример, програмери су најпре хранили ВИ готово свим што је икада написано на интернету: у блоговима, друштвеним мрежама, научним базама података или информативним порталима.

Њихов задатак је да предвиде најверојатнију следећу реч у реченици, а не да логички продру у проблем. „Оно што они раде је у суштини предвиђање следеће речи“, каже Пачеко. Статистички гледано.

Следећи корак

Пачеко, Сомензи и њихов тим се надају да ће развити сопствени систем ВИ који може све – да решава сложене загонетке и објасни како то ради. У ту сврху почињу са другом врстом загонетке под именом Хитори, која као и судоку, садржи мрежу бројева.

При томе се такође ослањају на нови приступ: такозвану неуросимболичку ВИ, која је још увек у раној фази развоја. Циљ је комбиновати меморију LLM-а са способношћу људског мозга да размишља логично.

„Људи говоре о растућим способностима вештачке интелигенције која може решавати ствари које не бисте очекивали", каже Пачеко. „Истовремено, није изненађујуће да су и даље лоши у многим задацима."

Коментари